|

Бит (от англ. binary digit; также игра слов: англ. bit — немного) м. скл — это наименьшая возможная единица измерения информации в вычислительной технике.

Наряду с битом используют байт как единицу измерения информации.

Если провести аналогию, то бит можно представить как букву, а байт — как слово. Как правило, байт равен 8 битам.

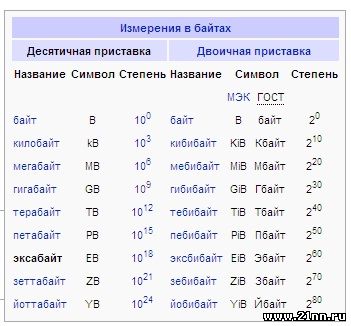

Большинство символов, которые Вы читаете сейчас с экрана монитора, имеют размер информации 1 байт. Так как бит и байт величины очень маленькие по своей сути, то их обычно используют с приставками кило-, мега-, гига-, тера- и т.д.

Поскольку в основе принципов работы большинства широко распространенных вычислительных систем используется двоичная система счисления, — это означает что в основе всех величин информации лежат числа с основанием 2. Таким образом 1 бит может принимать 2 значения: 1/0, истина/ложь, да/нет и т.п.

Так как байт состоит из 8 бит, это значит, что, 1 байт может содержать 2(*8) комбинаций т.е. 256. Как правило, такого количества комбинаций достаточно, чтобы закодировать большинство алфавитов.

Так считали на заре компьютерной эры. Поэтому, мы сегодня воспринимаем байт как 8 бит де-факто. Хотя могут быть сконструироватны системы в которых байт будет состоять из большего или из меньшего числа бит.

|